为什么使用了爬虫代理ip仍然爬不到数据?作者:数据无忧 时间:2020-09-18 13:24:53 |

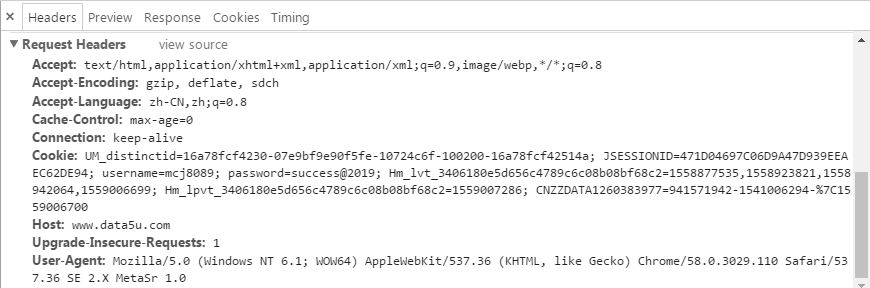

爬虫用代理IP之后为什么还遇到问题?很多朋友在使用了优质稳定代理IP、控制了访问速度和次数、设置了UserAgent、Referer等一系列方式的情况下,发现爬虫工作还是会遇到各种不好的情况,导致爬虫工作总是不那么顺利的进行,无法高效的爬取大量数据,按时完成每天的工作任务,问题出在哪里呢,有什么好的解决办法呢? 每个网站反扒策略不一样,所以需要具体问题具体分析。不过有些基本的操作还是要做好的,如下几点: 第一,使用高质量的代理ip; 第二,设置好header信息,不仅仅是UserAgent、Referer这两个,还有很多其他的header值,可以在浏览器中打开开发者模式(按F12)并浏览网址查看;  第三,处理好Cookie,如上图,把Cookies信息保存下来,然后再下次请求时带上Cookie; 第四,如果通过header和cookie还不能爬到数据,那么可以考虑模拟浏览器采集,常见的技术是PhantomJS 通过以上四步,基本上不会爬不到数据了。

福利:现在通过开发者购买代理IP,购买后联系客服最高可获

返现20%

到你的支付宝(最低35元,最高1440元)

无忧代理IP(www.data5u.com)原创文章,转载请注明出处。

|